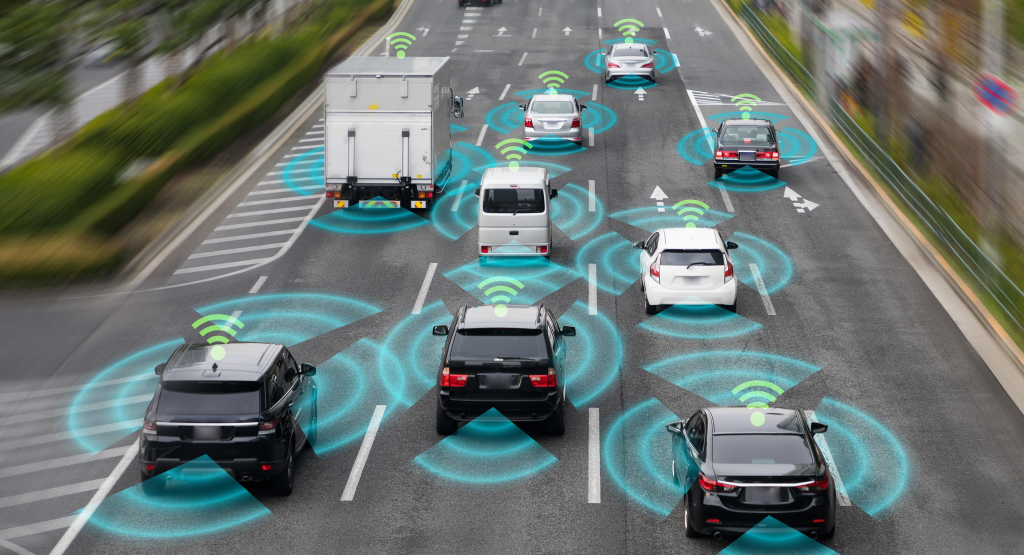

Os veículos autônomos estão redefinindo o conceito de mobilidade e segurança no trânsito. Ao operar sem a intervenção humana, esses veículos dependem de algoritmos avançados para tomar decisões complexas em frações de segundo. No entanto, essa capacidade de decisão também levanta uma questão fundamental: como esses veículos devem agir em situações que envolvem dilemas éticos e morais? A ideia de um carro sem motorista pode parecer simples e prática, mas as decisões que ele precisa tomar em cenários críticos – como escolher entre evitar um obstáculo e proteger a segurança dos ocupantes – exigem um debate aprofundado sobre a ética e a moralidade programadas nesses sistemas. Neste artigo, exploraremos como os veículos autônomos abordam as decisões morais, a importância de considerar a ética em sua programação e as responsabilidades envolvidas.

O Que São Decisões Morais em Veículos Autônomos?

As decisões morais em veículos autônomos referem-se às escolhas que o sistema precisa fazer em situações de conflito, onde a segurança ou o bem-estar de seres humanos pode estar em risco. Por exemplo, imagine um cenário onde o veículo autônomo precisa decidir entre desviar para evitar um pedestre que entrou na pista ou permanecer na trajetória e preservar a segurança dos ocupantes. Em casos assim, a decisão envolve julgamentos éticos complexos que desafiam a lógica binária dos computadores, exigindo que os sistemas de inteligência artificial sejam programados para considerar não apenas os fatores técnicos, mas também os valores morais.

Essas decisões são embutidas nos algoritmos que guiam o comportamento dos veículos autônomos, e elas determinam como o veículo responderá a diferentes situações. No entanto, a programação de decisões morais é uma tarefa complexa e controversa, pois não existe uma resposta universal para esses dilemas, e cada escolha implica em consequências que podem afetar vidas humanas de maneira imprevisível. Os engenheiros e programadores precisam, portanto, encontrar formas de codificar princípios éticos nesses veículos para que eles atuem de maneira responsável em situações críticas.

Por Que a Ética é Importante na Programação dos Veículos Autônomos?

A ética é um componente essencial na programação de veículos autônomos, pois define o padrão de comportamento que esses veículos adotarão em cenários que envolvem decisões difíceis. A ética não se limita a decisões técnicas; ela abrange valores e princípios que orientam a conduta de forma a minimizar danos e preservar a vida. Como os veículos autônomos operam em ambientes dinâmicos, onde as condições podem mudar rapidamente, eles precisam ser capazes de responder com base em diretrizes éticas que levem em conta tanto a segurança dos ocupantes quanto a dos pedestres e outros motoristas.

Sem uma base ética sólida, os veículos autônomos poderiam agir de maneira imprevisível ou insensível a situações que envolvem risco de vida, o que minaria a confiança pública nessa tecnologia. Além disso, a falta de uma orientação ética pode expor fabricantes e desenvolvedores a responsabilidades legais e morais, caso uma decisão do veículo resulte em danos. A programação ética dos veículos autônomos é, portanto, fundamental para assegurar que eles contribuam para uma mobilidade mais segura e justa, evitando decisões que possam resultar em consequências desastrosas para as pessoas ao seu redor.

Como os Algoritmos Interpretam Questões Éticas?

Os algoritmos dos veículos autônomos são projetados para processar informações e tomar decisões com base em uma série de regras e critérios previamente definidos. No entanto, interpretar questões éticas é um desafio para esses algoritmos, pois a ética humana não é linear ou facilmente traduzível em códigos binários. Para programar decisões éticas, os engenheiros incorporam diretrizes que simulam escolhas baseadas em normas de segurança, priorização de vida e minimização de danos, mas a interpretação dessas diretrizes pode variar conforme o contexto e a complexidade do cenário.

Uma abordagem comum é a criação de “árvores de decisão” éticas, onde o algoritmo avalia diferentes possíveis ações e escolhe aquela que minimiza o dano total. Entretanto, a questão da ética em veículos autônomos é ainda mais complexa quando consideramos dilemas onde qualquer escolha implica em um risco para alguma vida. Embora os algoritmos sejam capazes de identificar variáveis e calcular riscos, a interpretação ética desses fatores ainda depende da filosofia que embasa a programação. Assim, mesmo com avanços tecnológicos, a questão ética nos veículos autônomos continua a ser um dos maiores desafios para os desenvolvedores de IA.

Dilemas Morais: Decisões em Situações de Risco

Os dilemas morais nos veículos autônomos representam cenários onde qualquer decisão tomada pelo sistema pode resultar em uma consequência indesejada. Esses dilemas são especialmente desafiadores, pois envolvem a escolha entre múltiplas vidas ou a consideração de fatores como idade, número de ocupantes e grau de dano potencial. Por exemplo, em uma situação onde um pedestre atravessa inesperadamente a rua, o veículo autônomo pode ter que escolher entre desviar e colocar os ocupantes em risco ou continuar a trajetória e potencialmente atingir o pedestre.

Esse tipo de dilema moral, muitas vezes discutido no contexto do “problema do bonde” (um cenário clássico da filosofia ética), levanta questões sobre como os veículos autônomos devem ser programados para reagir a riscos e proteger a vida. Diferentes culturas e legislações podem interpretar esses dilemas de forma variada, tornando a programação ética uma tarefa ainda mais complicada. Esses dilemas mostram que os veículos autônomos, mesmo com toda a sua tecnologia avançada, precisam de uma programação que não apenas siga regras rígidas, mas que também tenha sensibilidade às complexidades e às nuances das decisões morais.

Quem É Responsável pelas Decisões de um Veículo Autônomo?

A questão da responsabilidade pelas decisões tomadas pelos veículos autônomos é uma das mais complexas e debatidas. Como esses veículos operam com base em inteligência artificial e algoritmos de programação, as decisões que eles tomam são, em última análise, resultado de instruções embutidas pelos programadores e engenheiros. No entanto, em caso de um acidente ou decisão moralmente questionável, surge a dúvida sobre quem deve ser responsabilizado: o fabricante, o desenvolvedor do software, o proprietário do veículo ou até mesmo o próprio sistema de IA.

Em muitos casos, as regulamentações ainda não estão totalmente preparadas para definir a responsabilidade nos incidentes que envolvem veículos autônomos. As empresas que desenvolvem esses veículos muitas vezes assumem a responsabilidade inicial, mas há um movimento crescente para criar leis e normas específicas que abordem a responsabilidade em situações envolvendo decisões éticas. Essa falta de clareza sobre a responsabilidade nos veículos autônomos é um aspecto que precisa ser resolvido para que o público aceite e confie totalmente nessa tecnologia. Afinal, entender quem é responsável pelas decisões do veículo é essencial para garantir uma condução autônoma ética e segura.

O Papel dos Fabricantes e Programadores nas Decisões Éticas

Os fabricantes e programadores dos veículos autônomos desempenham um papel crucial na definição das decisões éticas que esses veículos tomarão em situações de risco. Como os carros autônomos operam de maneira independente, cada escolha que eles fazem é baseada em códigos e diretrizes embutidos por suas equipes de desenvolvimento. Esses profissionais, portanto, precisam considerar cuidadosamente como programar as decisões para que o veículo atue de forma ética e responsável em uma variedade de cenários.

Os programadores são responsáveis por definir os parâmetros que o sistema de inteligência artificial usará para priorizar vidas, decidir sobre riscos e responder a emergências. Já os fabricantes têm a responsabilidade de garantir que as políticas de segurança e ética sejam rigorosamente implementadas e que as decisões programadas estejam em conformidade com as regulamentações locais. Ao mesmo tempo, as empresas precisam comunicar ao público que essas escolhas éticas estão sendo tratadas com seriedade e que os veículos autônomos não são apenas máquinas eficientes, mas também éticas. Portanto, o papel dos fabricantes e programadores vai além da tecnologia, envolvendo questões de responsabilidade social e confiança do consumidor.

Programar para Proteger a Vida: Qual Vida Priorizar?

Um dos maiores dilemas éticos enfrentados na programação dos veículos autônomos é a questão de qual vida priorizar em uma situação de emergência. Em um cenário onde um acidente é inevitável, como o veículo autônomo deve agir para minimizar o dano? Ele deve proteger os ocupantes a todo custo ou dar prioridade à vida de pedestres? Esse é um dilema conhecido na filosofia como o “problema do bonde”, onde cada escolha traz consequências éticas profundas e questionáveis.

Para lidar com essa questão, os engenheiros de veículos autônomos tentam programar os sistemas de IA para minimizar o risco geral e proteger o maior número possível de vidas. No entanto, essas decisões não são simples e envolvem um grau de subjetividade que a programação dificilmente consegue capturar. A questão de qual vida priorizar levanta debates não apenas técnicos, mas também culturais, pois diferentes países e sociedades podem ter opiniões variadas sobre a moralidade dessas decisões. Esse dilema demonstra que, embora os veículos autônomos representem um avanço significativo em segurança e tecnologia, eles também trazem à tona questões éticas para as quais a humanidade ainda não tem respostas definitivas.

Privacidade e Ética: Limites da Coleta de Dados em Veículos Autônomos

Com o avanço dos veículos autônomos, a coleta de dados tornou-se uma prática essencial para que esses carros possam operar de forma eficiente e segura. Esses veículos armazenam informações sobre rotas, padrões de condução, condições do ambiente e, muitas vezes, até dados pessoais dos ocupantes. No entanto, a coleta constante de informações traz à tona preocupações éticas relacionadas à privacidade dos usuários. Até que ponto é aceitável que um veículo autônomo armazene e analise dados pessoais?

A questão ética que se coloca é como equilibrar a necessidade de dados para o funcionamento seguro dos veículos autônomos com o respeito à privacidade dos indivíduos. Fabricantes e desenvolvedores precisam adotar práticas de transparência e permitir que os usuários escolham quais dados serão compartilhados. Além disso, a implementação de criptografia e a limitação do acesso aos dados são fundamentais para garantir que a privacidade seja preservada. Nesse contexto, os limites éticos da coleta de dados se tornam uma questão central para a aceitação pública dos veículos autônomos, uma vez que os usuários precisam sentir que suas informações estão protegidas e que sua privacidade é respeitada.

Transparência dos Algoritmos e o Direito dos Usuários de Saber

A transparência dos algoritmos é uma questão ética fundamental no uso de veículos autônomos. Como esses veículos tomam decisões complexas e muitas vezes baseadas em dilemas morais, os usuários têm o direito de entender como essas escolhas são feitas. Em outras palavras, os algoritmos que guiam as decisões dos veículos autônomos devem ser claros e compreensíveis para que os consumidores possam confiar que as decisões do carro estão alinhadas com padrões éticos aceitáveis.

A falta de transparência pode gerar desconfiança e impedir a adoção em larga escala dos veículos autônomos. Portanto, é responsabilidade dos fabricantes fornecer informações sobre a lógica dos algoritmos e permitir que os usuários compreendam, de forma simplificada, como o carro reage em situações de risco. Esse direito de saber é parte de um relacionamento ético entre os fabricantes de veículos autônomos e seus usuários, promovendo a confiança e a aceitação social da tecnologia. Assim, a transparência dos algoritmos não é apenas uma questão técnica, mas uma medida de respeito ao consumidor e à sociedade.

Regulamentação e Normas Éticas para Veículos Autônomos

À medida que os veículos autônomos se popularizam, a criação de normas e regulamentações éticas torna-se indispensável para garantir que esses veículos operem de forma responsável e segura. Países e organizações internacionais estão trabalhando para desenvolver diretrizes específicas que estabeleçam padrões para as decisões morais e éticas programadas nos veículos autônomos. Essas regulamentações abordam questões como a prioridade em situações de risco, a privacidade dos dados coletados e os limites da autonomia dos veículos em decisões complexas.

A criação de regulamentações éticas para veículos autônomos não apenas garante a segurança dos ocupantes e dos pedestres, mas também aumenta a confiança pública na tecnologia. Com normas claras, as empresas terão parâmetros sólidos para desenvolver seus veículos de maneira ética, enquanto os consumidores terão garantias de que a tecnologia segue princípios de segurança e respeito à vida. Além disso, a regulamentação permite responsabilizar fabricantes e desenvolvedores por possíveis falhas, criando um ambiente mais seguro e transparente para a evolução da mobilidade autônoma.

Casos Reais: Exemplos de Decisões Morais em Situações de Emergência

Ao longo dos anos, surgiram vários casos reais que ilustram os desafios das decisões morais enfrentados pelos veículos autônomos em situações de emergência. Em um exemplo amplamente discutido, um veículo autônomo de testes foi colocado em uma situação onde tinha que escolher entre manter a trajetória e arriscar um impacto com pedestres ou desviar e colocar em risco a segurança dos ocupantes. Esse caso evidenciou a complexidade dos dilemas morais que esses veículos enfrentam e gerou debates sobre a programação ética da tecnologia.

Outro caso envolveu um incidente em que o veículo não conseguiu prever o comportamento imprevisível de um pedestre, levando a uma colisão. Esses exemplos destacam a importância de incorporar uma programação ética robusta e de simular o maior número possível de cenários de emergência para que os veículos autônomos estejam preparados para tomar decisões seguras e responsáveis. Os casos reais mostram que, embora a tecnologia autônoma traga promessas de maior segurança, ela ainda enfrenta desafios éticos que precisam ser resolvidos para garantir uma adoção segura e responsável.

A Dificuldade de Programar a Moralidade: Perspectivas e Limitações

A programação da moralidade nos veículos autônomos é um dos maiores desafios enfrentados por engenheiros e desenvolvedores de IA. A moralidade humana é complexa e muitas vezes subjetiva, variando conforme a cultura, contexto e valores individuais. No entanto, ao programar veículos autônomos, os desenvolvedores precisam tomar decisões claras sobre como o carro reagirá em situações éticas complexas, como escolher entre proteger os ocupantes ou pedestres em caso de acidente inevitável.

Programar a moralidade é especialmente difícil porque os veículos autônomos operam com base em regras e algoritmos que, por sua natureza, não conseguem capturar nuances subjetivas. Embora sistemas de IA possam ser treinados para tomar decisões “éticas” em cenários simulados, eles ainda enfrentam limitações quando confrontados com situações inéditas ou moralmente ambíguas. Além disso, a moralidade humana não pode ser totalmente traduzida em código binário, o que significa que os veículos autônomos, por mais avançados que sejam, sempre terão limitações na compreensão e execução de julgamentos morais.

Inteligência Artificial e Ética: Até Onde a Tecnologia Pode Decidir?

A presença da inteligência artificial (IA) em veículos autônomos levanta uma questão fundamental: até onde a tecnologia deve ser responsável por tomar decisões que envolvem ética e moralidade? Os sistemas de IA são capazes de processar uma quantidade gigantesca de dados em tempo real e tomar decisões rápidas com base em algoritmos, mas essas decisões, por mais sofisticadas que sejam, ainda são limitadas por parâmetros programados pelos seres humanos. Em outras palavras, a IA em veículos autônomos não decide realmente; ela executa instruções e simula comportamentos éticos baseados em padrões e cenários previamente estabelecidos.

No entanto, a tecnologia tem suas limitações, e a programação da ética em IA ainda está longe de atingir uma moralidade genuína. A questão é até onde permitir que os veículos autônomos tomem decisões sem intervenção humana. Em última análise, a IA pode ajudar a reduzir acidentes e melhorar a segurança, mas a responsabilidade final pelas decisões morais talvez deva sempre recair sobre os desenvolvedores e fabricantes, que são os verdadeiros agentes responsáveis pelas escolhas programadas nesses veículos. Esse limite ético na IA exige que a indústria de veículos autônomos encontre um equilíbrio entre inovação e responsabilidade.

A Opinião Pública sobre Ética e Veículos Autônomos

A aceitação dos veículos autônomos pela opinião pública depende diretamente de como esses veículos abordam as questões éticas e morais. Estudos mostram que muitas pessoas ainda desconfiam da tecnologia autônoma, especialmente em relação à capacidade dos carros autônomos de tomar decisões em situações críticas. A opinião pública reflete uma preocupação legítima sobre como os veículos decidirão em situações de risco, e se essas decisões serão moralmente aceitáveis ou alinhadas com valores humanos.

Além disso, os consumidores também demonstram receio em relação à falta de transparência dos algoritmos e à ausência de regulamentações claras sobre a responsabilidade ética dos veículos autônomos. A opinião pública tem um papel importante na definição das diretrizes éticas para esses veículos, uma vez que a aceitação social é essencial para a adoção em larga escala da tecnologia. As empresas, portanto, devem trabalhar não só para desenvolver tecnologias seguras e éticas, mas também para comunicar de forma clara como essas decisões são tomadas e como a ética é incorporada nos veículos autônomos.

Conclusão: Um Futuro Seguro e Ético para a Mobilidade Autônoma

O avanço dos veículos autônomos promete transformar a mobilidade urbana, mas também desafia os limites da tecnologia ao trazer à tona questões de ética e moralidade que precisam ser cuidadosamente abordadas. A programação de decisões morais nesses veículos é um desafio contínuo e complexo, pois envolve escolhas que impactam vidas humanas e que, muitas vezes, são subjetivas e difíceis de definir em termos binários. A criação de veículos autônomos eticamente responsáveis requer uma combinação de algoritmos avançados, regulamentação sólida e uma abordagem transparente e sensível às preocupações da sociedade.

Para que os veículos autônomos sejam realmente seguros e aceitos pelo público, é essencial que o setor de tecnologia e as autoridades de regulamentação trabalhem juntos para desenvolver normas que protejam os usuários e garantam uma conduta ética clara. Com o comprometimento em proteger a vida e respeitar a privacidade, a mobilidade autônoma pode, de fato, proporcionar um futuro mais seguro e sustentável para todos. A ética não é um detalhe na programação desses veículos; é a base que dará legitimidade e confiança à condução autônoma no futuro.

Perguntas Frequentes sobre Ética e Decisões Morais em Veículos Autônomos

- Por que a ética é importante na programação de veículos autônomos?

A ética é crucial para garantir que os veículos autônomos tomem decisões responsáveis em situações de risco, protegendo tanto os ocupantes quanto os pedestres e assegurando uma conduta alinhada com valores humanos. - Como os veículos autônomos lidam com dilemas morais?

Veículos autônomos são programados para minimizar danos e proteger vidas, mas enfrentam dificuldades em interpretar dilemas complexos, pois a moralidade humana é subjetiva e difícil de traduzir em algoritmos. - Quem é responsável pelas decisões éticas de um veículo autônomo?

A responsabilidade pelas decisões éticas geralmente recai sobre os fabricantes e programadores, pois são eles que definem as diretrizes e parâmetros que orientam as escolhas do veículo em situações de risco. - Os veículos autônomos podem decidir até onde agir de forma ética?

A inteligência artificial dos veículos autônomos é limitada pelos parâmetros programados, e não possui uma “moralidade própria”. Até onde a tecnologia decide é uma questão controlada pelos seres humanos responsáveis pela programação e desenvolvimento. - A opinião pública influencia a ética nos veículos autônomos?

Sim, a opinião pública é essencial para definir diretrizes éticas e regulamentações. A aceitação social dos veículos autônomos depende de como a sociedade vê a ética desses veículos, o que incentiva fabricantes a abordar a ética de forma transparente.